Dans son Plan Stratégique de promotion de la santé 2018-2022, la Région bruxelloise incitait les opérateurs à tendre vers une démarche évaluative la plus réaliste qui soit, les convoquant ainsi à une plus grande réflexivité de leurs pratiques et à un meilleur embrassement des réalités de leurs interventions. Une porte s’ouvrait à la prise en compte de la complexité des pratiques de terrain, une opportunité pour les opérateurs de s’éloigner des logiques évaluatives classiques basées sur la hiérarchisation d’objectifs peu différenciables des résultats, trop déterminants des interventions, observés et mesurés à travers des critères et des indicateurs vécus comme réducteurs.

Nous proposons de parcourir les étapes d’un cycle d’évaluation réaliste (ER) en les illustrant par des fragments d’expérimentations issus du dispositif de recherche mené par RESO, le centre d’expertise en promotion de la santé de l’UCLouvain, dans le cadre de la mise en œuvre du Plan¹. Nous avons choisi d’explorer « la mise à l’épreuve du réel » (paraphrase de l’ER) d’un nouveau programme de formation intitulé Tous acteurs de prévention destiné aux professionnel·les de l’éducation et du social santé.

Ce ne sont pas les interventions qui produisent des effets…

Ce qui préoccupe, lorsque l’on étudie un phénomène complexe dans un environnement complexe, ce n’est pas seulement de savoir si une intervention A produit un effet attendu B, à l’image d’un médicament dont on peut tester l’efficacité sans nécessairement en connaître précisément le mécanisme d’action². Il s’agit plutôt de comprendre ce qui se passe dans la boîte noire de l’intervention : quelle logique a été suivie dans la réalité par l’intervention ?

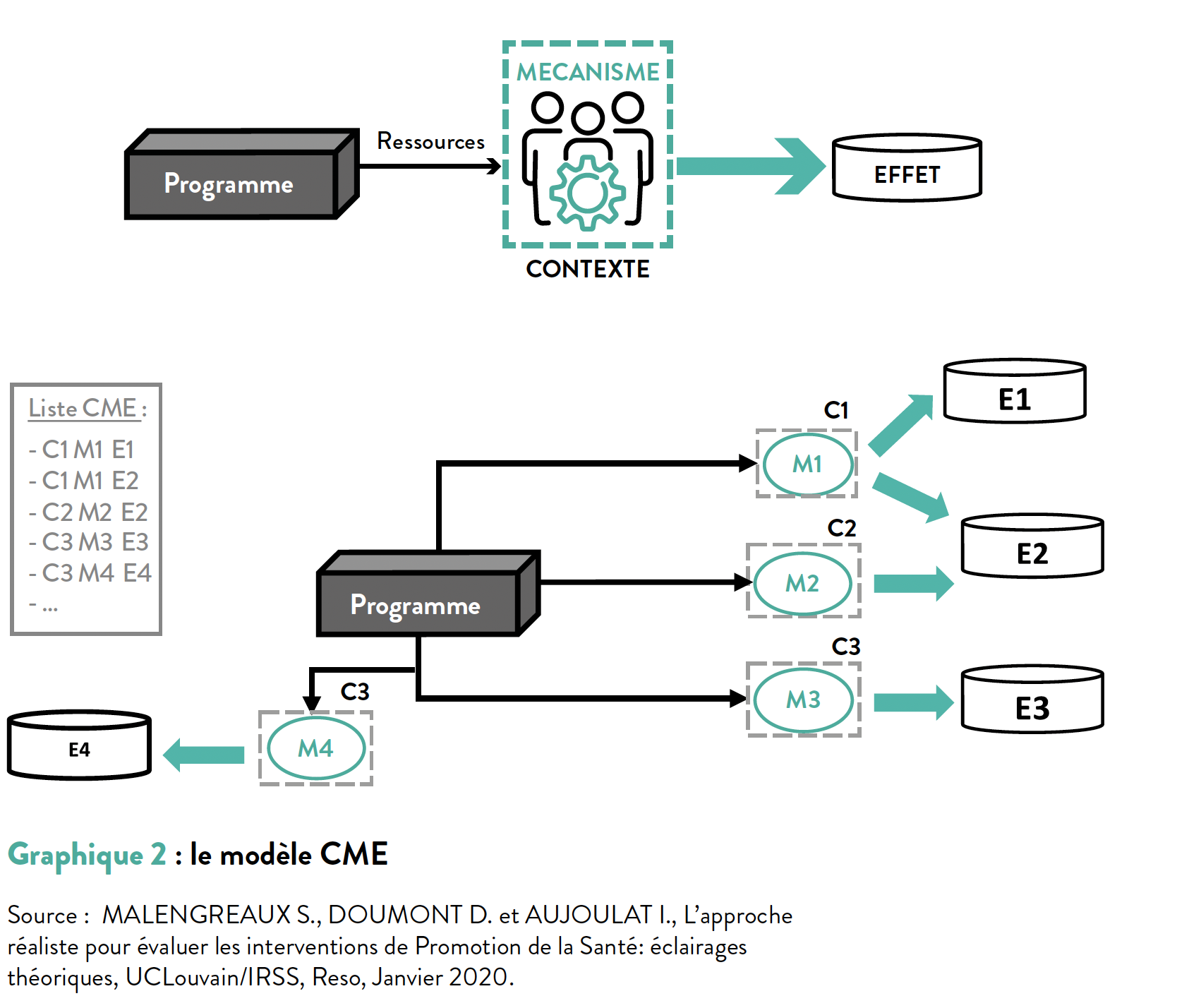

L’idée centrale de l’ER est que la rencontre entre les ressources créées par l’intervention et certaines caractéristiques du contexte va actionner (ou non) un ou plusieurs mécanismes au sein des individus, collectivités, environnements, qui produiront à leur tour des effets. Par opposition au modèle de causalité « successionniste », l’ER repose sur le modèle de causalité générative qui consiste à formuler des hypothèses de fonctionnement en termes de « Contexte + Mécanisme = Effet ». Les liens de causalité entre une intervention (ou programme) et ses effets peuvent alors être expliqués par plusieurs configurations Contexte-Mécanismes-Effets (CME). Celles-ci sont testées dans le processus évaluatif afin de modifier et améliorer l’intervention (programme).

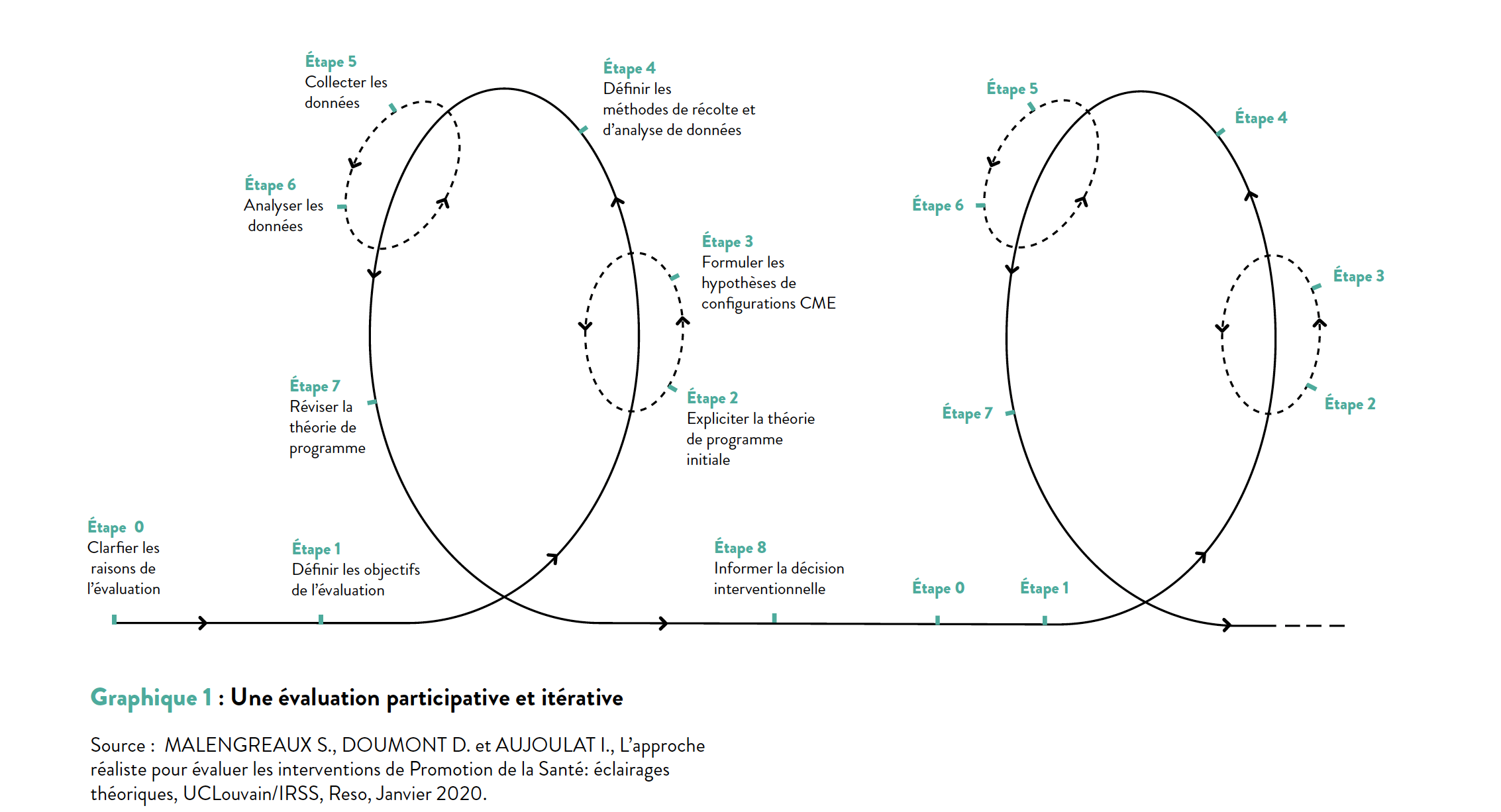

La configuration C-M-E n’est qu’une des étapes d’un processus participatif et itératif, représenté par le graphique 1.

Graphique 1 : Une évaluation participative et itérative

S’accorder sur le sens

Le premier temps, celui qui va indéniablement contribuer à l’engagement des équipes dans une démarche sur le long terme, doit être consacré à la construction d’un sens commun à la démarche évaluative. Il s’agit ici de trouver un point d’équilibre entre « rendre des comptes », concept auquel les équipes sont accoutumées et « se rendre compte » phénomène qui appelle à la réflexivité et l’adaptation des pratiques. L’enjeu à ce stade est de rassembler l’équipe autour d’une ou plusieurs questions à élucider (questions évaluatives) ainsi que de susciter la rencontre des un·es et des autres autour du pourquoi de la démarche : « À quoi et à qui vont servir les réponses aux questions investiguées ? ».

Dans notre exemple, les participants se sont accordés sur la question évaluative suivante (ce choix a bien sûr été orienté par la nécessité d’utiliser l’ER dans le cadre de la recherche) : « Mieux comprendre comment, pour qui et dans quelles circonstances, la formation favorise l’intégration d’un rôle d’acteur de prévention tabagique chez les participant·es ».

Préparer l’évaluation en s’appuyant sur les concepts vécus et reconnus

Il convient ensuite de déterminer collectivement la clé de voûte du dispositif. La théorie du programme initial comme on la nomme (bien qu’intuitive pour la plupart des équipes) pose concrètement la question du « comment et pourquoi l’équipe pense que l’intervention va fonctionner », elle repose sur des suppositions qui présument les conditions de la transformation (de situations), en s’inspirant de la littérature, des rapports ou plus spécifiquement, dans le cadre qui nous concerne, des concepts reconnus de la Promotion de la santé tels que la littératie en santé, les compétences psychosociales, la capacitation, l’estime de soi.

Dans le cas de la recherche, cette étape a connu quelques détours en dehors du champ de l’ER – notamment parce qu’il s’agissait d’une nouvelle formation et non d’un programme existant, et que cela impliquait de partir de l’expérience plus large des formateurs et non de l’expérience de l’intervention à évaluer. L’équipe est finalement parvenue à identifier un modèle théorique qui permettait de formuler la théorie de programme initiale : Les paradoxes entre identité personnelle et professionnelle³. À ce stade on peut dire que le chantier de l’ER est prêt, les hypothèses d’efficacité peuvent se construire sur la base des notions de légitimité, d’expertise et de cohérence dans la pratique des professionnel·les.

Par opposition au modèle de causalité « successionniste », l’ER repose sur le modèle de causalité générative

Les équipes sont invitées à déplacer le focus depuis le classique résultat (de l’intervention) vers les conditions de réalisation du changement

Formuler les scénarios d’efficacité les plus probables

Les équipes sont invitées à déplacer le focus depuis le classique résultat (de l’intervention) vers les conditions de réalisation du changement à travers l’analyse des interactions nuancées entre des ressources mises à disposition des bénéficiaires et le contexte de l’intervention. C’est l’étape clé de la formulation des hypothèses de configuration Contexte-Mécanisme-Effet

Le contexte s’entend comme l’ensemble des facteurs extérieurs qui préexistent à l’intervention (les nomes, valeurs, caractéristiques des publics, événements historiques, conditions économiques, environnement social et physique…). Le mécanisme peut se comprendre comme la réponse (cognitive, émotionnelle, consciente, inconsciente, positive, négative…) des personnes aux ressources mises à disposition par l’intervention. Le mécanisme est activé par des facteurs contextuels et exerce une sorte de force qui conduit aux effets⁴ . Chaque configuration doit pouvoir ensuite être lue comme une phrase liant le contexte au mécanisme et à l’effet (CME).

Exemple (1) de configurations issues de l’expérimentation

Ressource : Questionnement du schéma classique de prévention – Encouragement à l’introspection et la prise de recul quant à sa pratique – Partage d’expérience

Représentation moralisatrice et normative de la prévention (C) – Sentiment d’efficacité personnelle (M) – Développement d’une posture d’acteur·ice de prévention (E)

Hypothèses d’efficacité : si la formation permet aux participant·es de questionner leurs représentations de ce en quoi consiste « faire de la prévention » auprès des jeunes (ressources) dans un contexte où ces représentations sont le plus souvent associées à une vision moralisatrice et normative de la prévention (contexte), alors ils et elles se sentiront davantage capables de jouer ce rôle dans le cadre de leurs missions professionnelles (efficacité personnelle – mécanisme), ce qui contribuera à développer une posture d’acteur·ice (effet).

Exemple (2) de configurations issues de l’expérimentation

Ressource : (Re)définir le rôle d’acteur de prévention – Créer une relation de confiance avec le jeune

Statut tabagique des participants (C) – Sentiment de légitimité et sentiment de cohérence (M) – Développement d’une posture d’acteur·ice de prévention

Autre hypothèse d’efficacité : si la formation permet aux participant·es de développer une approche de prévention en cohérence (ressources) avec leur statut tabagique (contexte), alors ils se sentiront davantage légitimes et motivés (sentiment de légitimité et sentiment de cohérence – mécanisme), ce qui contribuera à ce qu’ils développent une posture d’acteur·ice de prévention (effet).

Affiner les scènes, réécrire le scénario

Cette étape vise à disposer d’un matériau permettant d’explorer les hypothèses de fonctionnement. Les méthodes de collecte peuvent être multiples, les plus courantes sont l’entretien associé au focus group, le questionnaire, l’observation.

L’analyse des données doit permettre de confirmer, infirmer ou adapter les configurations CME, et générer des conclusions à des profondeurs variables. Celles-ci peuvent aller de l’infirmation et précision des éléments de la théorie de programme initiale ET du repérage d’éventuels nouveaux éléments, jusqu’à la confirmation, l’infirmation et la précision de la relation de causalité entre les éléments C, M et E de chaque configuration initialement formulée ET l’identification de nouvelles configurations CME.

Dans notre exemple, la collecte des données s’est organisée en trois temps. D’abord, par la collecte de données en amont de la formation concernant le profil et les attentes des participant·es (par téléphone). Puis, tout au long de la formation, à l’aide d’une grille d’observations que les formateur·ices complétaient après chaque journée de formation. Enfin, par l’utilisation d’une technique d’animation servant à la fois l’évaluation et l’apprentissage des participant·es à la formation. Le dernier temps d’évaluation a été réalisé à l’aide d’un focus group et d’un questionnaire⁵.

En ce qui concerne l’analyse et les conclusions l’équipe est allée jusqu’à une étape intermédiaire qui consiste à pouvoir confirmer, infirmer, préciser la nature (C, M ou E) de chaque élément anticipé ET attribuer une nature (C, M ou E) aux nouveaux éléments. À ce stade, les rapports complets n’ont pas été rendus publics . Cependant, des capsules vidéos, ont permis aux équipes partenaires de partager leur expérience⁶.

L’analyse des données doit permettre de confirmer, infirmer ou adapter les configurations CME, et générer des conclusions à des profondeurs variables

L’ER se pratique-t-elle (en dehors de la recherche) ?

Bien que présentant un potentiel intéressant, l’ER demeure peu appliquée chez nous et n’a pas fait l’objet d’une revalorisation dans le cadre de la révision du Plan stratégique de promotion de la santé. La Belgique est à la traîne en cette matière et les outils manquent cruellement.

L’ER chamboule également les pratiques évaluatives et présente chacune de ses étapes comme un réel défi. Alors que les CME foisonnent intuitivement dans les pratiques de terrain en promotion de la santé, leur identification comme telles n’est pas évidente. La notion de « contexte », par exemple, demande de se détacher de la vision descriptive et dichotomique habituelle (freins vs. leviers) des aspects du contexte, pour permettre d’observer et comprendre de quelle manière ces aspects interagissaient avec l’intervention et en expliquent les effets. La notion de « mécanisme » peut questionner dans la mesure où elle induit de focaliser la recherche sur les forces cognitives et psychologiques des individus (mécanismes intérieurs) sans prendre suffisamment en compte les déterminants sociaux de la santé en tant que levier central en promotion de la santé⁷.

Reconnue pour son ouverture à la complexité du réel, sa mise en œuvre paraît difficile, nécessitant une collecte de données détaillée, souvent sur des périodes longues, et demandant des ressources importantes en temps, budget et compétences pour être efficace. Dans le cadre des ressources limitées dont disposent les opérateurs en promotion de la santé, l’approche réaliste peut être difficile à déployer de manière exhaustive, notamment pour des programmes de grande envergure ou dans des contextes de faible financement.

Sa mise en œuvre paraît difficile, nécessitant une collecte de données détaillée, souvent sur des périodes longues

Si appliquer l’évaluation à la lettre relève du défi, s’en inspirer, pour améliorer ses pratiques et revendiquer des cadres évaluatifs qui tendent vers plus d’observation réaliste, relève de la volonté d’expérimenter, d’innover et de remettre en question.

Enfin, dans un article paru très récemment dans Global Health Promotion, les auteur·ices mettent en lumière les conditions favorables à la pratique de l’évaluation réaliste chez nous⁸ : soutenir et accompagner le dialogue, les échanges, le questionnement et l’engagement en faisant appel à des intervenant·es extérieur·es ; penser la rencontre entre les repères de l’évaluation réaliste et de la promotion de la santé ; monter en compétences d’évaluation des équipes ; tirer profit d’un accompagnement à des niveaux individuel, collectif et organisationnel ; inscrire la démarche dans une politique publique axée sur une culture de la réflexivité.

-

MALENGREAUX S., L’évaluation réaliste pour évaluer les conditions d’efficacité d’interventions de promotion de la santé : Retour sur 4 expériences en Région de Bruxelles-Capitale, UCLouvain/IRSS, Reso Avril 2024.

-

BLAISE P., Culture qualité et organisation bureaucratique, le défi du changement dans les systèmes publics de santé, thèse en sciences de la santé publique, ULB, 2004. Voir Chapitre 2 : L’évaluation réaliste : une méthodologie appropriée pour étudier l’introduction du management de la qualité dans les systèmes de santé.

-

Voir COURTY P., Fumer du cannabis et faire de la prévention. L’exemple des futurs professionnels de l’éducation pour la santé. Vie sociale et traitements. 2008 ; 98(2) : 20-30.

-

MALENGREAUX S., DOUMONT D. et AUJOULAT I., op. cit.

-

MALENGREAUX S., op.cit.

-

Voir : https://uclouvain.be/fr/instituts-recherche/irss/reso/prosess.html

-

MALENGREAUX S., op.cit.

-

MALENGREAUX S. et al., Analyse des conditions à l’utilisation de l’évaluation réaliste par des équipes de promotion de la santé : résultats d’une étude de cas multiples en région bruxelloise (Belgique), IUHPE – Global Health Promotion, à paraître.